La philosophie n’a pas bonne presse. Discipline universitaire produisant des intellectuels éthérés ayant perdu tout sens commun, elle peine à ancrer ses discussions dans le quotidien. Parfois, cependant, on peut se réjouir de la mise à l’épreuve politique de l’idéal philosophique. On assiste alors, immanquablement, au dépassement de l’idéologie par la pensée pure. En témoigne, le récent engouement universel pour le numérique et sa « philosophie ». Où en sommes-nous ?

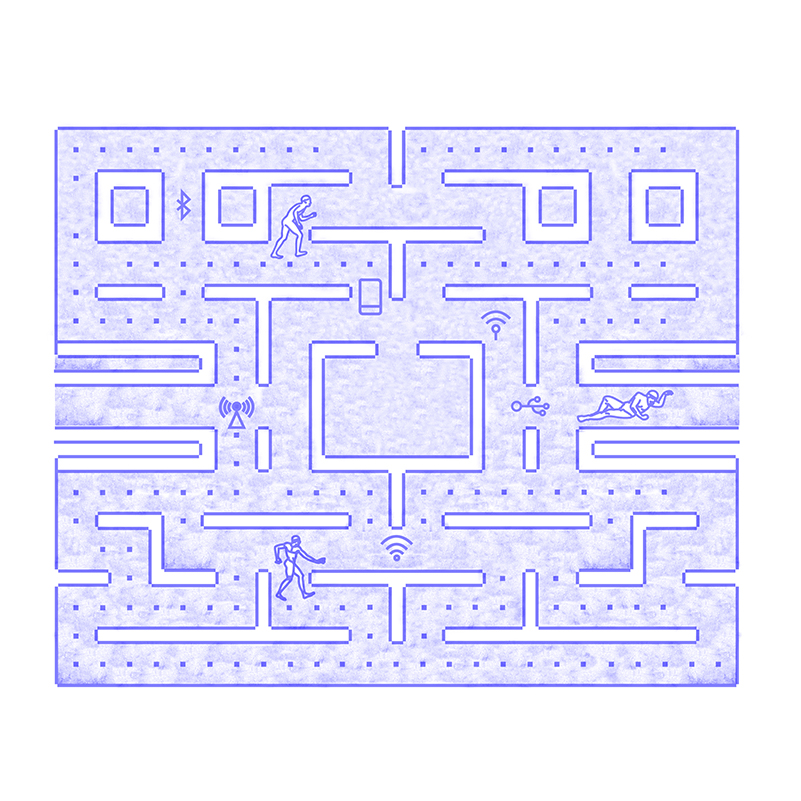

Quel que soit le problème, la solution est maintenant numérique, c’est-à-dire smart, un mot anglais qui, à l’origine, se traduit, selon le contexte, par chic, élégant, intelligent, habile, vif, prompt… Les gens smart sont l’élite, la crème, la « haute » ; les objets « smart » représentent donc un « must » si on ne veut pas avoir l’air aussi paupérisé qu’on ne l’est. Le numérique étant smart, on ne doit plus se poser la question de savoir s’il faut numériser les choses, les institutions, ou les humains. La réponse est, en effet, immédiate : non seulement on n’a pas le choix, mais l’urgence est grande. On n’a pas le choix car c’est le progrès et que ce progrès se matérialise, pour ceux qui l’acceptent, par de vrais salaires et des profits remarquables, tandis que ceux qui le refusent perdent leur emploi, font faillite et se suicident (a minima socialement). C’est urgent, car de grandes puissances rivales se lancent corps et biens dans l’aventure et que, vous l’aurez deviné, nous sommes déjà très en retard. La rhétorique du retard est irrésistible : la décision a déjà été prise par de plus malins que nous ; nous avons jusqu’ici manqué de vision et, surtout, de pragmatisme ; il est donc temps de s’y mettre sans ergoter. Choses, institutions et humains doivent passer sous ses fourches caudines. Notons, du reste, la triple conjonction de deux arguments : d’une part, le numérique permet de tout optimiser ; d’autre part, le numérique permet de tout monétiser. On aimerait ajouter, sans précautions oratoires superflues, qu’il permet de sécuriser les choses, les institutions et les citoyens, mais il n’est pas difficile de comprendre que son développement s’est accompagné d’une cyber-surveillance omniprésente (bien qu’elle passe largement inaperçue) et d’une cyber-criminalité tout aussi prometteuse en termes de profits immédiats.

Cela étant, il serait déraisonnable de s’inquiéter pour l’emploi, car, on ne le sait pas assez, une destruction créatrice (Schumpeter, 1942) est toujours à l’œuvre dans nos sociétés de plein emploi (qui s’ignorent) et les gains de productivité permettront la création de plus de valeur et de (légèrement) plus d’emplois qu’on en détruira. La démonstration de cet oxymore est cependant d’autant plus hasardeuse que le but poursuivi par la robotique est de créer un simulacre humanoïde parfait. Mais, peut-être, faut-il conclure que ce simulacre sera un grand nostalgique et qu’il sera heureux d’embaucher des humains pour prendre en charge les inévitables tâches ancillaires ? En pareil cas, cela ferait de lui un thérapeute bénévole, car la santé mentale de ses employés ne pourra être que borderline. (François Roustang propose de traduire borderline par « frontalier(1) ».) Ou alors, créé par des schizophrènes, il ne pourra qu’être psychotique « ça-même » ? Précisons les enjeux afin de tenter de démêler l’écheveau.

Numériser les choses est en route depuis que les ordinateurs sont devenus domestiques. En 1984, Apple commercialise le Macintosh, qui annonce la fulgurante propagation des ordinateurs personnels. L’univers multimédia se développera vers la fin des années 1980 avec l’apparition des CD-ROM et la possibilité de gérer différents médias simultanément (musique, son, image, vidéo). La Toile, ou World Wide Web, naît en 1991 (son ancêtre militaire direct, l’ARPANET, date de 1969) ; elle semble annoncer le déclin du livre et la marche forcée vers la numérisation de tous les médias. La souplesse de l’interactivité de la Toile, et surtout sa faculté de donner la parole à tous (ce qui nécessite quand même une familiarité avec l’outil informatique, l’accès à un ordinateur relié à une ligne à haut débit et un fournisseur d’électricité fiable) pourrait cependant être remise en question lors du passage au Web 3.0 : sous prétexte de l’épuisement des adresses (« IPv4 »), de lutte contre les fake news, la pornographie, etc., il s’agirait de contrôler le contenu des sites ; sous prétexte de sauver la presse professionnelle, etc., l’entoilage deviendrait beaucoup plus coûteux. La mobilophonie fait son apparition en Europe en 1994, et elle s’est très rapidement imposée comme un élément indispensable au quotidien de la plupart des consommateurs. La conclusion est simple : avec l’explosion de l’utilisation de la Toile et l’accroissement de la pression publicitaire, nous sommes submergés d’informations de moins en moins utiles et de plus en plus téléguidées par des médias et les réseaux sociaux « à l’ordre(2) ».

Numériser les institutions va dès lors de soi : à mesure que les choses se numérisent et que le multimédia se généralise, les institutions ont pu embrayer et redéfinir les modalités de leur bonne gouvernance. Non seulement la gestion interne des entreprises et des organismes publics, mais les relations qu’ils entretiennent avec leurs clients et les citoyens sont systématiquement numérisées, traitées, et archivées par le biais des réseaux. Mis à part les militaires et les entreprises de recherche sensible (et encore), ils n’utilisent plus d’intranet au sens où un serveur local (souvent de la famille VAX-11) gérerait un réseau local, mais par contre on le virtualise en bridant internet par firewall (pare-feu) interposé. L’intranet est maintenant sur l’internet (le « cloud » et la NSA) et on peut dormir tranquille en terme de vie privée.

Enfin, numériser – et monétiser – les humains eux-mêmes est le chantier du XXIe siècle. Tel est, fondamentalement, le projet du transhumanisme ; il consiste à implanter de la technologie (hardware et software) dans l’organisme afin de guérir un handicap, d’améliorer les performances physiques et mentales, voire d’immortaliser le sujet, tout ébaudi d’avoir pu s’offrir ce que son voisin cherche encore à financer. Tout semble possible à celui qui s’accroche à la foi techniciste. Elle s’est appropriée deux pistes distinctes, mais convergentes : l’intelligence artificielle (IA) et la robotique. En effet, les psychologues cognitivistes ont finalement avancé la thèse hardie de la cognition incarnée (embodied cognition(3)) : on ne connaît, et on n’est conscient qu’à travers son inscription dans l’espace et dans le temps. Cela veut donc dire deux choses : d’une part, l’IA ne fera pas de progrès significatifs tant qu’elle ne disposera pas d’un « corps » ; d’autre part, les robots ne peuvent espérer être autonomes sans détenir un semblant d’intelligence (qu’il reste bien sûr à définir). Les sceptiques seront rassurés d’apprendre que, dans les années 1960, on voyait l’ordinateur comme une sorte de cerveau (cybernétique : « to think is to compute »), tandis qu’à présent on comprend le cerveau comme une sorte d’ordinateur (science cognitive : « to compute is to think(4) »). Reste la question, douloureuse entre toutes, des émotions. Comme au blackjack, les chercheurs doublent ici la mise (« double down ») : la fin du XXe siècle se caractérise en effet par ce que certains ont nommé le « tournant affectif(5)» de la pensée occidentale. Il ne s’agit toutefois pas, par exemple chez Antonio Damasio (1994), de prétendre que les émotions, en tant qu’émotions, sont au cœur du vécu humain, qu’elles désignent le mystère même de l’existence, mais bien de montrer, vignettes cliniques et PET scan à l’appui, que l’exercice efficace de la pensée requiert un apport émotionnel. Tant et si bien que pour les cognitivistes Minsky et Picard(6), « la question n’est pas de savoir si des machines intelligentes peuvent éprouver des émotions, mais s’il peut y avoir des machines intelligentes qui n’en auraient pas(7)». Forts de leurs expertises cliniques respectives, ils soulignent le rôle essentiel que les émotions jouent dans les prises de décision, la perception, l’apprentissage et l’exercice de la pensée. On savait que les émotifs ne formaient pas de bons décideurs ; il restait à découvrir que, sans émotion, rien n’est décidable. En termes platoniciens : bien que l’idéal semble être de dételer les chevaux nommés désir et émotion afin de laisser la pensée se penser elle-même, dans une autarcie qui a reçu un nom en 1943 – l’autisme (8)–, sans émotion et sans désir, la raison ne va simplement nulle part. Picard écrit donc que « si nous souhaitons créer des ordinateurs vraiment intelligents qui soient capables d’interagir naturellement avec nous, il faut leur conférer la capacité de reconnaître, de comprendre, et même d’éprouver et d’exprimer des émotions(9)». On obtient, semble-t-il, un paradoxe du style « sois spontané » appliqué à un algorithme… Nous atteignons ici un point de bifurcation. Ou bien on accepte de poser l’émotion au centre de l’expérience humaine (voire, comme Whitehead, au centre de toute expérience, quelle qu’elle soit) et l’opacité constitutive de l’existence est reconnue comme telle ; ou bien on cherche à intégrer l’émotion dans le cadre matérialiste, possiblement réformé par les dernières spéculations quantiques, et rien n’échappe à la raison. L’enjeu est de taille : si le monde et l’expérience que nous en avons devaient être totalement transparents à la raison, le déterminisme évacuerait définitivement toute forme de spontanéité et, avec elle, tout sens existentiel. On voit que la question n’est plus uniquement philosophique : elle devient centrale dans le cadre du projet du développement de l’IA et elle l’a toujours été en psychiatrie. Depuis Emmanuel Peterfreund (1971) et surtout John Bowlby (1969), le computationnalisme (ou « computational theories of emotion ») a séduit de nombreux psychiatres, Kenneth Colby allant même jusqu’à concevoir un simulateur de paranoïa(10). Aurait-il renoncé à modéliser le raisonnable pour lui préférer, dès l’abord, l’improbable algorithme de la folie ?

Tel est le contexte dans lequel certains croient pouvoir écrire avec le plus grand sérieux du monde que le développement de l’IA permettra en plus le traitement de maladies cataloguées comme psychiatriques : « C’est le cas par exemple de l’autisme ou du trouble de l’attention avec ou sans hyperactivité. Certains robots peuvent être utilisés pour améliorer le développement émotionnel de ces personnes et leur apprendre à canaliser leur énergie(11). » L’automate en question est Pepper, un androïde (robot humanoïde) créé par SoftBank Robotics après son rachat du pionnier Aldebaran Robotics ; il a été présenté à une conférence le 5 juin 2014 et il est en vente depuis 2015. Il s’agit d’un « robot compagnon », qui « a pour vocation de s’intégrer dans les foyers, reconnaître les membres de la famille et s’adapter en fonction de chaque utilisateur. Il est notamment capable de tenir des conversations et de divertir les enfants(12)». Sa spécificité est la détection des expressions faciales, du ton et du champ lexical particulier employés par son « interlocuteur ». Ne nous étonnons donc pas qu’à terme, ce robot puisse « remplacer certains postes occupés jusqu’à présent par des êtres humains. […] Le futur est plus que jamais en marche…(13) ».

Observez attentivement le raisonnement général : d’une part, ce type de robot devrait remplacer toute une série de fonctions qui sont encore, à l’heure actuelle, occupées par des humains ; d’autre part, il n’y a pas péril en la demeure car on s’attend à ce que la révolution robotique crée des emplois. Lesquels ? Ceux qui demandent, précisément, des facultés que l’on ne trouve que chez les humains, comme la capacité de reconnaître les émotions (l’empathie) et de s’y adapter (la sympathie). Pour le dire plus clairement, c’est-à-dire en anglais : les robots devraient remplacer la plupart des professions nécessitant des hard skills, sans affecter directement celles nécessitant des soft skills. Mais la logique robotique elle-même (« embodied cognitition » + « computational theories of emotion ») exige pragmatiquement – il ne saurait être question d’idéologie – la colonisation du territoire des soft skills. Si le lecteur ne comprend pas comment cette double contrainte peut être dépassée, c’est probablement à cause de son impossibilité. Le raisonnement particulier est tout aussi édifiant : alors qu’il n’y a aucun consensus sur la nature exacte de l’autisme ou sur l’étiologie des troubles de l’attention, la robotique serait à même d’aider les patients. Ce que le contact humain ne peut réussir, l’interaction avec la machine le fera. La seule conclusion possible a été tirée par La Mettrie dès 1747 : l’Homme est une machine. Le fait que les schizophrènes se comprennent comme des machines ne peut, de toute évidence, qu’étayer cette thèse. Mettons un peu d’ordre dans nos idées.

Premièrement, pourquoi est-ce l’autisme qui est évoqué ici plutôt que la schizophrénie ? Sauf erreur, depuis Kanner (1943), l’autiste est celui qui naît schizophrène et la question fondamentale demeure bien de comprendre la schizophrénie elle-même et de cerner ses causes (organique/génétique et/ou psychologique/traumatique). Le fait que les autistes ne soient pas nécessairement institutionnalisés et qu’on les associe parfois à des surdoués (les Asperger) explique sans doute leur apparition dans l’argument. Deuxièmement, que peut-on dire de la schizophrénie elle-même ? Il faut tout d’abord savoir qu’il peut ne pas y avoir de symptômes (signes extérieurs) clairs signalant l’état schizophrénique. Ensuite, la grille de lecture qui offre le plus d’avantages comparatifs est celle que l’on doit à Ronald D. Laing. Dans Le Moi divisé (1960)(14), il explique que, face à un réel perçu comme menaçant, le sujet, cherchant désespérément à se protéger, renforce comme il le peut ses défenses naturelles et culturelles. Il opère tout d’abord à l’aide de stratégies d’évitement du réel : amnésie des événements traumatiques, anesthésie des douleurs, conversion psychosomatique (hystérie), phobies, assuétudes, toxicomanie, désocialisation, repli sur soi, mutisme, dépersonnalisation, dissociations. Parfois les tensions se relâchent en conséquence, mais le processus laisse un humain désaffecté et indésirable : sans affects (ou le moins possible) et sans désirs (autre que la volonté de vivre caché) apparents. Souvent, c’est l’angoisse qui s’installe et une nouvelle stratégie est mise en place afin d’y survivre, tout simplement. Les comportements à risque, ainsi que les comportements auto-destructeurs, tels que l’auto-mutilation, la promiscuité sexuelle et les tentatives de suicide, deviennent progressivement inévitables. Tantôt on peut pister l’incrémentation de la paranoïa ; tantôt le basculement est soudain et définitif. N’oublions pas qu’étymologiquement schize veut dire coupure. En somme, une fois la stratégie protective verrouillée, le sujet se retrouve prisonnier de son propre dispositif sécuritaire et de son « jeu de rôle ». Une personne insécurisée ou anxieuse est susceptible de développer deux jeux de défenses complémentaires : d’une part, sa conscience de soi fait retrait dans un « moi intérieur » totalement inaccessible ; d’autre part, le système « moi intérieur/faux moi » est séparé du corps et ce dernier du monde : les perceptions sont en conséquence tronquées et les actions vaines. Être libre, c’est alors être inaccessible, entre autres, au regard ; c’est être devenu totalement opaque. En comprenant la psychose comme une tentative désespérée de préserver son intégrité psychique, Laing envisage la schizophrénie à la fois comme déficit communicationnel radical – un effondrement ou breakdown – et comme voyage intrapsychique – une percée ou breakthrough – à visée sotériologique. Plus précisément : il considère la schizophrénie comme un « passage » vers une existence plus authentique, comme un voyage initiatique, transformateur(15). La richesse dramatique de cette stratégie ne rend que plus urgente une approche existentielle et humaniste.

Troisièmement, afin de préciser les enjeux, il est important d’introduire une nouvelle catégorie clinique : la sociopathie. À la différence du schizophrène, le sociopathe agit dans le monde d’une façon rationnellement interprétable, algorithmique, ce qui ne veut toutefois pas dire qu’elle puisse être totalement anticipée. La passion et le désir, s’ils existent chez lui, appartiennent à un moi profond ; seule s’exprime une rationalité froide, machinique. (On pourrait reprendre ici de larges pans de l’analyse de Guattari et Deleuze, en remplaçant « schizophrénie » par « sociopathie ».) On peine à déceler chez lui des traces de délire ou un signe de pensée irrationnelle, mais on ne découvrira pas non plus d’affects (et donc d’empathie, de remords et de honte) ou de désirs (et donc de jouissance dans l’instant présent). Le sociopathe ne rêve probablement pas ; sa vie se déroule comme un programme que personne n’a écrit et auquel il se raccroche comme à un radeau. Il peut éprouver des difficultés à suivre les détails d’un tel plan de vie. Il est, en conséquence, contraint de mimer les affects et les désirs afin de masquer son handicap. Confronté à un observateur perspicace, le sociopathe apparaîtra sous la lumière fade du charme superficiel, de la fausseté et de l’hypocrisie chroniques. Bref, le sociopathe prétend avoir, manifester et identifier des émotions qu’il n’a pas. Par un long processus d’essai/erreur, il peut tromper ses interlocuteurs. Ne retrouve-t-on pas ici, très précisément, le portrait-robot de nos androïdes haut de gamme ?

Afin de ne pas alourdir l’argument, on ne dira rien de l’hyperactivité, dont la cause première est clairement, n’en déplaise aux récents spécialistes(16), l’hygiène de vie et la massification de l’enseignement. Que conclure ? Croire que l’autisme puisse faire l’objet d’une thérapie machinique est caractéristique du sociopathe technophile. Lorsque l’argument est étendu à la numérisation de l’enseignement, il ne fait que rendre ce sentiment encore plus vif. Suivons le fil (à couper le beurre) : les hard skills sont les compétences quantifiables, pouvant donc faire l’objet d’une évaluation objective et diplômante ; les soft skills sont des compétences plus transversales, comme par exemple l’écoute, la pédagogie, l’empathie, l’adaptabilité, la créativité, la gestion du stress(17)… Ces apprentissages soft doivent être inculqués, non pas par humanisme, mais afin d’être employables, c’est-à-dire de pouvoir inlassablement améliorer les produits, processus ou services dont on a la responsabilité. Ils peuvent être définis en extension(18) : la pensée critique et la capacité d’induction, la collaboration internationale, le leadership, la flexibilité et l’adaptabilité aux bouleversements technologiques, l’esprit d’initiative et d’entreprendre, la communication orale et écrite, la capacité à accéder à l’information et à analyser sa pertinence et son exactitude, la curiosité et l’imagination, l’empathie (réflexive, émotionnelle, cognitive), la créativité. À bien y regarder, on voit toutefois mal comment enseigner de telles soi-disant compétences ; tout au plus peut-on créer un climat favorable à l’épanouissement des individus. A minima, il s’agit de susciter une atmosphère permettant à la fois l’individuation et la solidarité ; a maxima, des pratiques plus exigeantes peuvent être invoquées, mais elles sont de l’ordre d’une ascèse gratuite, pas d’un cursus payant(19). Tout ceci ne veut bien sûr pas dire qu’il soit interdit de vendre cher et vilain de la vanité et de la vacuité, pourvu qu’elles soient spectaculaires.

L’éthos scolaire et académique est simple : l’école doit prendre soin de l’employabilité des élèves et l’université celle des étudiants, ce qui veut dire que, dans un environnement de plus en plus automatisé, les compétences « soft » demeurent aussi importantes que les compétences « hard », que la mise en concurrence des élèves (étudiants) est toujours d’actualité, et que la compétition des écoles (universités) entre elles, et des enseignants en leur sein, doit également être favorisée dans un souci très démocratique de transparence. Plus que jamais, le marché de concurrence pure et parfaite se définit par l’atomicité de l’offre et de la demande, l’homogénéité du produit, la transparence du marché et la mobilité parfaite. L’école (l’université) privatisée sera donc aux prises avec ces axiomes idéologiques (et dystopiques) : atomicité de l’offre et de la demande (chaque agent est une goutte d’eau dans la mer du marché) ; homogénéité du produit (il existe des marchés distincts pour chaque type de produit) ; transparence du marché (information parfaite des agents) ; mobilité parfaite (libre entrée, libre sortie et absence d’obstacles à la circulation des facteurs de production)(20).

On le sait, il faut viser l’excellence, qu’on retrouve la contradiction robotique ou pas. Si l’utilisation des TICE numérise l’esprit sans pouvoir aucunement libérer son humanité, on prétend exactement le contraire, notamment à cause du retour théorique du tutorat et du préceptorat. En clair : on reconnaît maintenant l’inefficacité chronique de l’enseignement de masse – si ce n’est, bien sûr, qu’historiquement, l’enseignement public a été utilisé afin de rendre les foules dociles et de refouler l’hydre du communisme (c. 1870), de renforcer le patriotisme dans un contexte colonialiste (c. 1880), de combler le déficit professionnel après la dernière hécatombe mondiale (c. 1946), de réduire l’enseignement à l’état de marchandise certifiante (c. 1979), de participer à l’économie de la connaissance (c. 1999 ; i.e., « Knowledge economy » des usuels World Bank, European Union, OECD), et, finalement, de bifurquer les emplois de première classe avec ceux déclassés (c. 2016, i.e., « Mc & Mac jobs »). Plus précisément, l’impératif de la formation continue (continuing education) et de l’apprentissage tout au long de la vie (lifelong learning) – merci d’apprécier la différence – peut se traduire par l’inutilité fondamentale de la formation acquise, fût-elle universitaire. Tout diplôme doit être perçu comme frappé d’obsolescence (technique, fonctionnelle, et programmée), tandis que le travailleur est supposé incapable de s’adapter par lui-même, et que son milieu professionnel est jugé incapable de le former ou préfère sous-traiter…

Résumons. Que doit rechercher l’école ? Le profit. Comment ? En développant une offre de formation qui corresponde très précisément à la demande des entreprises grâce à un vrai département de « ressources humaines » exploitant les derniers outils psychométriques et les incitants salariaux adéquats. Elle attirera alors les meilleurs élèves et pourra s’offrir les meilleurs enseignants, ceux qui ont pour plan de carrière de gagner 1,5 million $ par an et de rouler dans une Lamborghini avec une plaque immatriculée Dick(21). Que demandent les entreprises ? Du numérique, version hard, à savoir des compétences informatiques pointues, et du numérique version soft, c’est-à-dire un entregent et un leadership entrepreneurial et managérial qui permettent d’optimiser la machinisation de la vie. Peut-on avoir foi dans la destruction créatrice d’emplois et de sens ? Même si, dans le passé, il a pu y avoir des exemples d’une telle paradoxale intercession, l’idée même du remplacement des postes de travail humains, hard et soft, par des algorithmes et des droïdes la falsifie définitivement, cela tombe sous le sens commun.

De même, si on pose la question de l’impact de la numérisation sur l’enseignement, on obtient une condamnation sans appel. La création d’emplois soft et la préservation d’un corps professoral tout entier aliéné par sa libéralisation orwellienne ne peuvent être qu’une mesure temporaire nécessaire du point de vue de la robotisation universelle. Promouvoir l’enseignement numérique équivaut à considérer la schizophrénie comme compétence à développer toutes affaires cessantes. Avant de devenir des machines, on commencera par penser machine. Malheureusement, cette transformation ne sera jamais complète, et il faudra donc se résoudre à une forme de schize entre nos contingentes palpitations existentielles et la nécessaire interface avec le droïde cliniquement sociopathe.

Michel Weber

- François Roustang, Comment faire rire un paranoïaque ?, Odile Jacob, 1995.

- « Imaginez, lance l’universitaire américain Robert McChesney, que le gouvernement prenne un décret exigeant une réduction brutale de la place accordée aux affaires internationales dans la presse, qu’il impose la fermeture des bureaux de correspondants locaux ou la réduction sévère de leurs effectifs et de leurs budgets. Imaginez que le chef de l’État donne l’ordre aux médias de concentrer leur attention sur les célébrités et les broutilles plutôt que d’enquêter sur les scandales associés au pouvoir exécutif. Dans une telle hypothèse, les professeurs de journalisme auraient déclenché des grèves de la faim, des universités entières auraient fermé à cause des protestations. Pourtant, quand ce sont des intérêts privés en position de quasi-monopole qui décident à peu près la même chose, on n’enregistre pas de réaction notable » (Columbia Journalism Review, New York, janvier-février 2008, cité par Serge Halimi in Le Monde diplomatique, oct. 2009).

- Francisco J. Varela, Evan Thomson, Eleanor Rosch, L’Inscription corporelle de l’esprit. Sciences cognitives et expérience humaine. Traduit de l’anglais par Véronique Havelange [1991], Paris, Éditions du Seuil, 1993.

- Cf. Jean-Pierre Dupuy, Aux origines des sciences cognitives, Paris, La Découverte Textes à l’appui. Série sciences cognitives, 1994.

- Patricia T. Clough, « The Affective Turn: Political Economy, Biomedia and Bodies », in Theory, Culture & Society, 25.1, 2008, pp. 1–22.

- Marvin Minsky, The Society of Mind, New York, Simon & Schuster, 1985 ; The Emotion Machine: Commonsense Thinking, Artificial Intelligence, and the Future of the Human Mind, New York, Simon & Schuster, 2006. Rosalind W. Picard, Affective Computing, Cambridge (Mass.), The Massachusetts Institute of Technology Press, 1997.

- « La question n’est pas de savoir si les machines intelligentes peuvent éprouver des émotions, mais si les machines peuvent être intelligentes sans émotions » (Minsky, The Society of Mind, 1985, p. 163).

- Leo Kanner, « Autistic disturbances of affective contact », Nervous Child, 2, 1943, pp. 217–250.

- Rosalind W. Picard, Affective Computing, p. x. ; cf. p. 38 et passim.

- Emmanuel Peterfreund, Information, Systems, and Psychoanalysis: An Evolutionary Biological Approach to Psychoanalytic Theory, New York: International Universities Press, 1971. John Bowlby, Attachement et perte. I. L’Attachement [1969] (trad. de l’anglais par Jeannine Kalmanovitch) ; II. La Séparation [1973] (trad. de l’anglais par Bruno de Panafieu) ; III. La Perte : tristesse et dépression [1980] (trad. de l’anglais par Didier E. Weil), PUF, 1978, 1978, 1984. Kenneth Mark Colby, Artificial Paranoia : A Computer Simulation of Paranoid Processes, Pergamon Press Inc., 1975.

- Olivier Chastel (éd.), Accompagner la robotisation de l’économie, Les études du Centre Jean Gol, p. 25.

- https://fr.wikipedia.org/wiki/Pepper_(robot).

- Olivier Chastel (éd.), ibidem.

- Ronald David Laing, Le Moi divisé. De la santé mentale à la folie [1960]. Essai traduit de l’anglais par Claude Elsen, Stock, 1970. Cf. Gilles Deleuze et Félix Guattari, Capitalisme et schizophrénie I. L’Anti-Œdipe [1972]. Nouvelle édition augmentée, Les Éditions de Minuit, Critique, 1973, p. 156.

- Pour tout ceci, voir M. Weber, Ethnopsychiatrie et syntonie. Contexte philosophique et applications cliniques (Jacques Flament Éditions, 2015) et Pouvoir, sexe et climat. Biopolitique et création littéraire chez G. R. R. Martin (Cénacle de France, 2017).

- Le concept d’« attention-deficit disorder (ADD) with or without hyperactivity » date du DSM-III, c’est-à-dire de 1980.

- Olivier Chastel (éd.), Accompagner la robotisation de l’économie, Les études du Centre Jean Gol, p. 29.

- Olivier Chastel (éd.), ibidem, pp. 29–30.

- M. Weber, « Can one teach creativity ? », Vesselin Petrov and Adam Scarfe, Rhythm, Process, and Poiesis: Education from a Whiteheadian Point of View, Newcastle upon Tyne, Cambridge Scholars Publishing, 2019.

- Frank H. Knight, Risk, Uncertainty, and Profit, Houghton Mifflin, 1921.

- Olivier Chastel (éd.), op.cit., p. 45. Cf. Michel Weber, Éduquer (à) l’anarchie. Essai sur les conséquences de la praxis philosophique, Éditions Chromatika, 2008